n8n 使用入门

在低代码自动化领域,n8n凭借其强大的灵活性和丰富的节点生态,成为越来越多开发者的首选。

前置准备

使用 Docker 方式安装n8n无需关注 Node.js 版本,环境隔离性更好,是新手最推荐的方式。

确保你的电脑已经安装了Docker环境。如果你还没有Docker,可以先通过以下方式快速安装:

- Windows:直接下载Docker Desktop;

- Mac:通过Homebrew��或官网镜像安装;

- Linux:使用对应的包管理工具安装;

安装步骤

步骤 1:检查 / 安装 Docker

执行以下命令检查 Docker 是否安装:

docker -v

docker compose version # 检查 Compose(Docker 20.10+ 已内置)

未安装的话:

- Windows/macOS:下载Docker Desktop并安装(安装后启动 Docker Desktop,确保右下角 / 状态栏显示 Docker 运行中);

- Linux:参考Docker 官方文档 安装。

步骤 2:创建持久化目录(关键)

为了避免容器重启后丢失工作流数据,先创建本地目录存储 n8n 数据:

# macOS/Linux

mkdir -p ~/n8n/data

# Windows(PowerShell)

mkdir $HOME\n8n\data

步骤 3:启动 n8n 容器

用Docker Compose启动,这样更易管理,比较推荐。

- 创建 docker-compose.yml 文件(可放在任意目录,如 ~/n8n/):

version: "3"

services:

n8n:

image: docker.n8n.io/n8nio/n8n

container_name: n8n

ports:

- "5678:5678"

volumes:

# n8n数据挂载(存储工作流、数据库)

- ${HOME}/n8n/data:/home/node/.n8n

environment:

- N8N_HOST=0.0.0.0

- N8N_PORT=5678

- N8N_LOG_LEVEL=info

restart: always # 开机自启/容器崩溃自动重启

- 进入 docker-compose.yml 所在目录,执行启动命令:

docker compose up -d # -d 表示后台运行

步骤 4:访问与验证

-

浏览器访问

http://localhost:5678,首次登录创建账号即可使用; -

查看容器状态(确认运行正常):

docker ps # 查看运行中的容器,能看到 n8n 容器即正常

docker logs n8n # 查看 n8n 日志,排查启动问题

步骤 5:常用 Docker 操作

# 停止 n8n 容器

docker stop n8n

# 重启 n8n 容器

docker restart n8n

# 彻底删除 n8n 容器(数据卷已持久化,删除容器不丢数据)

docker rm -f n8n

# 更新 n8n 镜像(升级版本)

docker pull docker.n8n.io/n8nio/n8n

docker compose down && docker compose up -d

使用入门

我们以一个读取本地txt文件,并通过AI将文件内容二次优化后再输出到本地(创建新的txt文件)为例,做一个n8n的入门介绍。

浏览器访问 http://localhost:5678,第一次打开页面的时候,应该是这样的:

-

你可以点击加号,看到右侧会有很多节点以及分类。我们可以选择

Trigger manually这个节点作为入口节点。 -

添加完

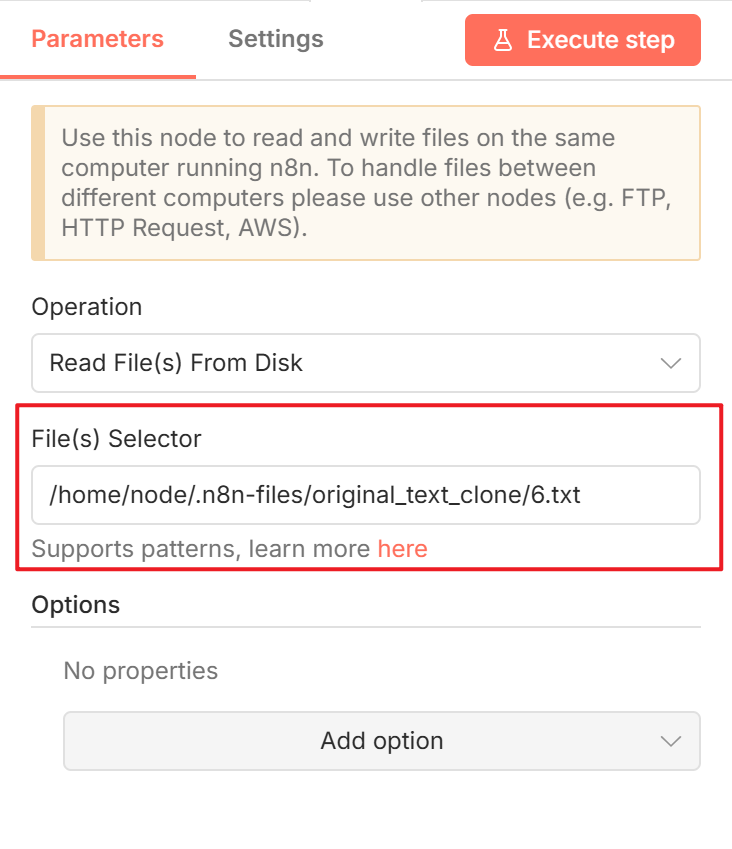

Trigger节点后,接着我们添加读取本地文件的节点。点击Trigger节点右侧的加号,找到Read/Write Files from Disk这个节点,选择Read Files From Disk。要填写被读取文件的文件路径:

还记得我们之前配置的docker-compose.yml文件吗?那个文件我们配置了映射:

volumes:

# n8n数据挂载(存储工作流、数据库�)

- ${HOME}/n8n/data:/home/node/.n8n

我们要读取文件需要安装映射的路径来读,而不是docker容器外的文件系统路径(电脑路径),这时候你可能会想到,把我们要读取的文件放到${HOME}\n8n\data目录下,然后在n8n的节点上配置/home/node/.n8n/xxx.txt这个路径即可。这种想法没问题,但测试运行n8n工作流时发现会报错,原因在于这个文件路径是n8n的数据挂载点,我们没有权限读取其中的文件内容。

一个解决的办法是再配置一个n8n允许访问的目录,修改docker-compose.yml文件增加一个volume:

volumes:

# 原有n8n数据挂载(存储工作流、数据库)

- ${HOME}/n8n/data:/home/node/.n8n

# 新增:本地文件目录 → 容器白名单目录(n8n允许访问)

- ${HOME}/n8n/files:/home/node/.n8n-files

然后运行docker restart n8n重启一下。把我们要读取的文件放到${HOME}\n8n\files目录下(记得新建files目录)。

接着回到Read File那个节点,配置正确的路径:

/home/node/.n8n-files/6.txt

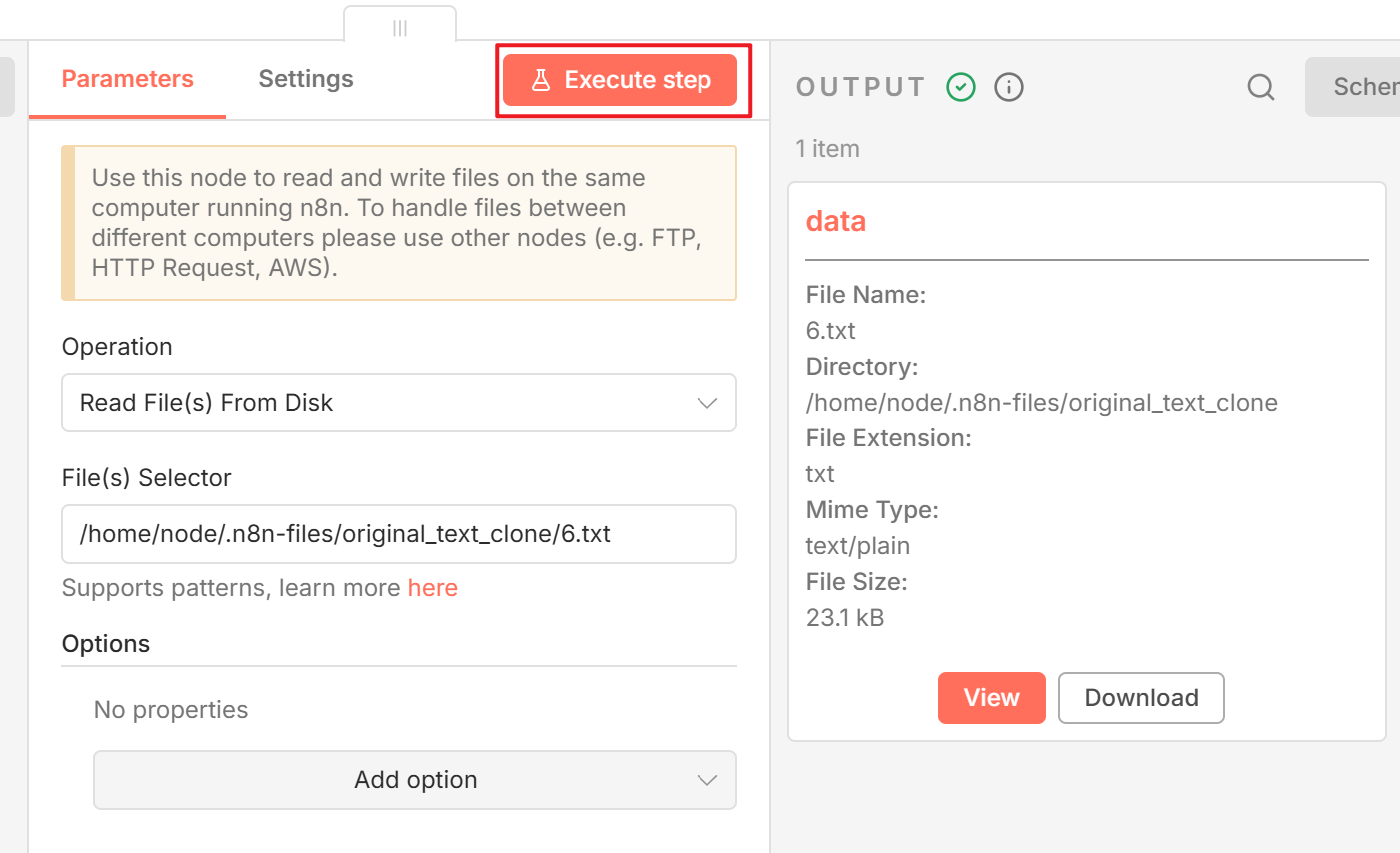

点击Execute step会发现读取成功(右侧有了文件信息):

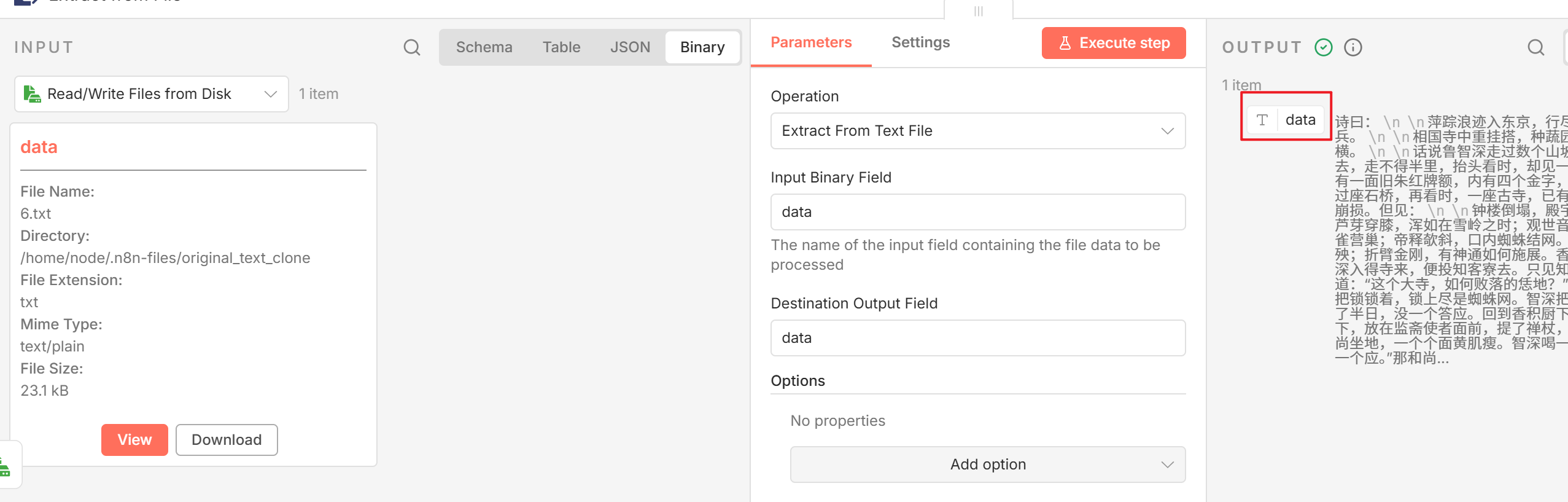

Read File节点需要与Extract from File节点配合使用,添加Extract from File节点,后点击Execute step就可以看到右侧的内容正是我们的文件的内容。

- 接着我们为

Extract from File节点添加后续节点。有了文本后,我们可以调用大模型。

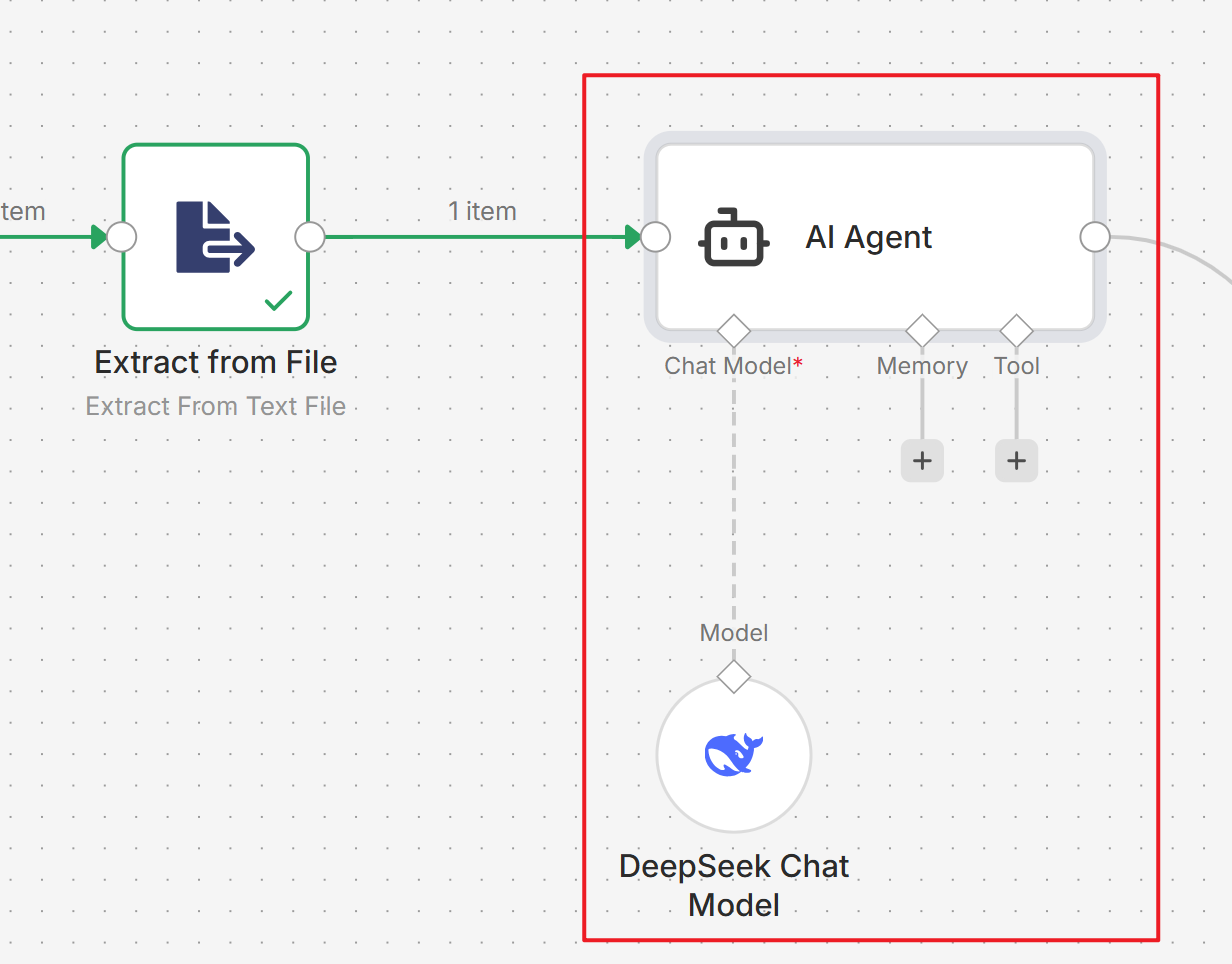

找到AI Agent节点,然后这个节点的Chat Model挂载DeepSeek Chat Model节点:

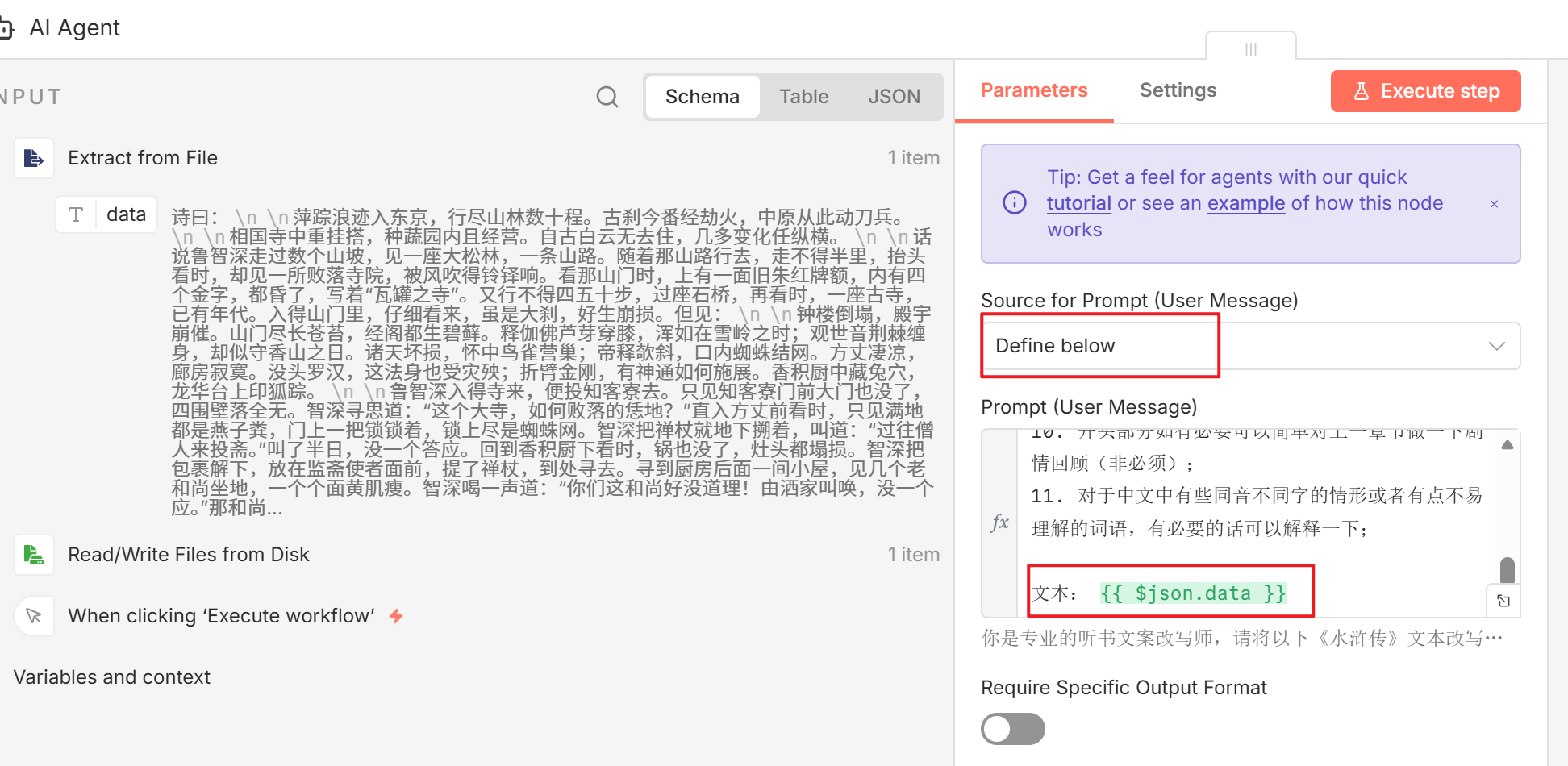

- 我们双击点开

AI Agent节点,选择Define below,这时下方的Prompt输入框就会打开,我们给AI写一些提示词,并拖拽左侧的data字段到Prompt输入框中,n8n在执行工作流时就会将文件里读取的数据传给AI。

在运行AI Agent之前记得先到DeepSeekAPI平台注册申请API Key。

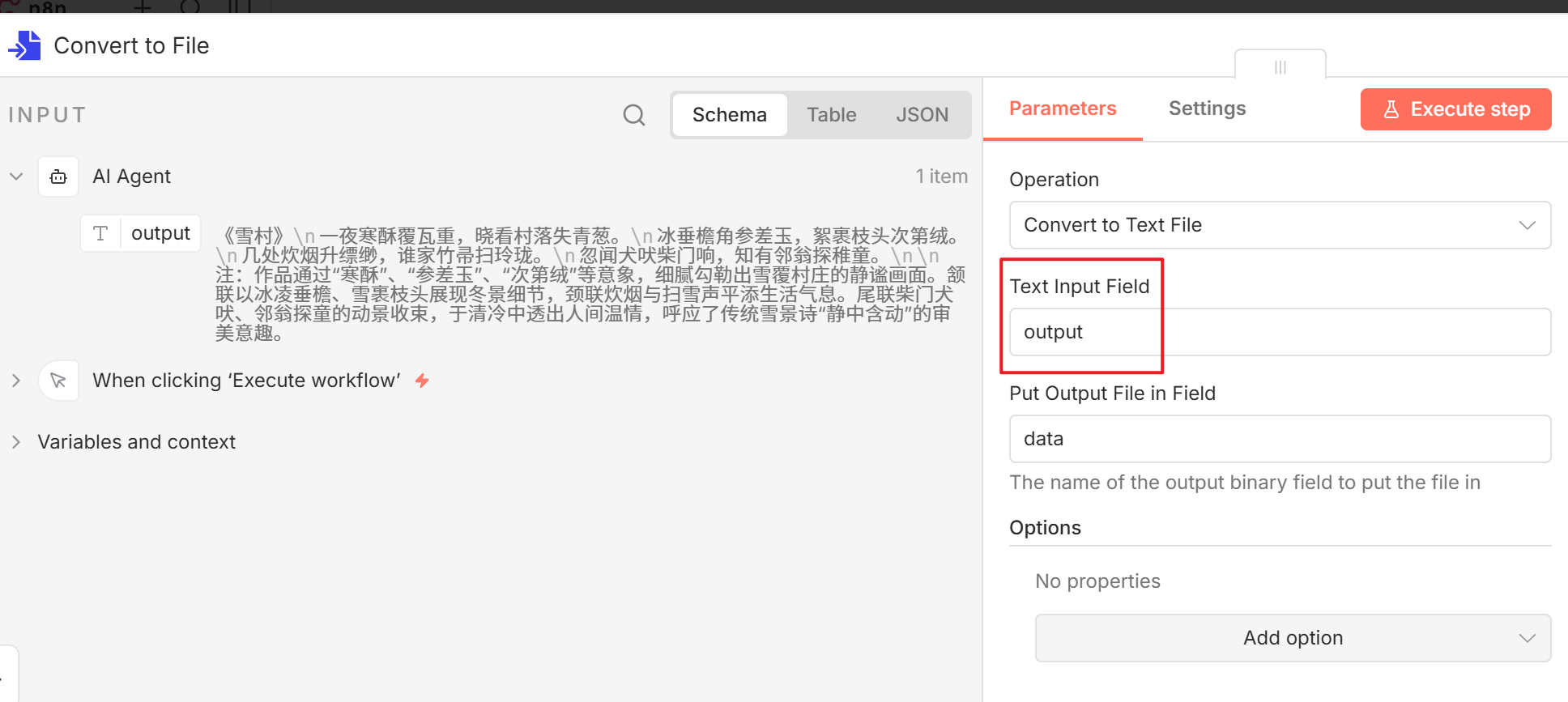

- �运行AI Agent节点后就可以看到AI给过来的答复了。接着就是把AI的回答存到本地,用到的节点与前面读取文件时相似,但是反过来的,我们要先生成文件对象,然后将文件对象写入到本地。

AI Agent右侧连接Convert to File节点,配置如下:

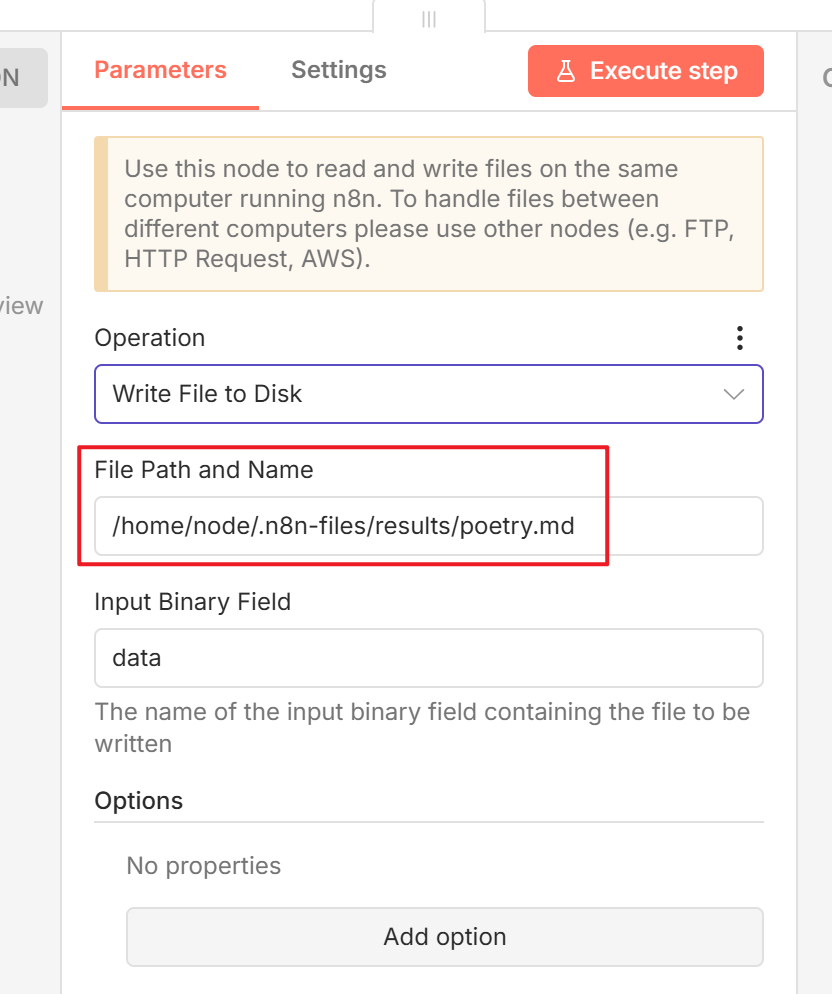

然后连接Read/Write Files from Disk节点,配置如下(注意是前面配置的docker路径):

运行后就可以看到文件夹中多了一个文件。

n8n连接本地部署到AI模型

除了使用云端的AI模型外,我们也可以使用本地部署模型作为n8n的节点。以Ollama 为例,我们实践一下如何调用本地模型。

Ollama是一种用于快速下载、部署、管理大模型的工具。Ollama官网(可能需要梯子才能访问):https://ollama.com

点击下载安装即可。下载安装完成后,打开命令行终端,输出ollama -v可以验证是否安装完成。

本地模型下载

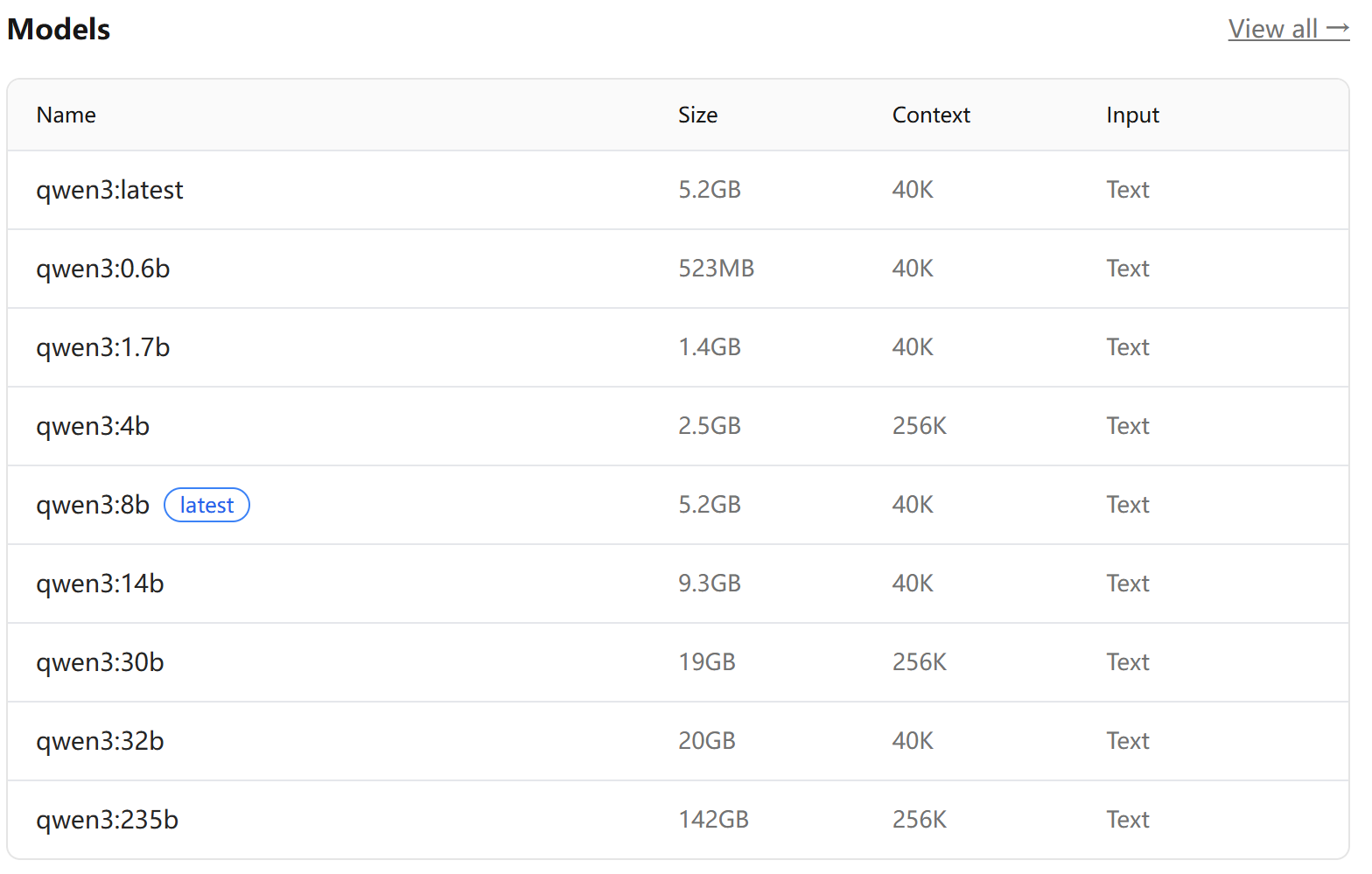

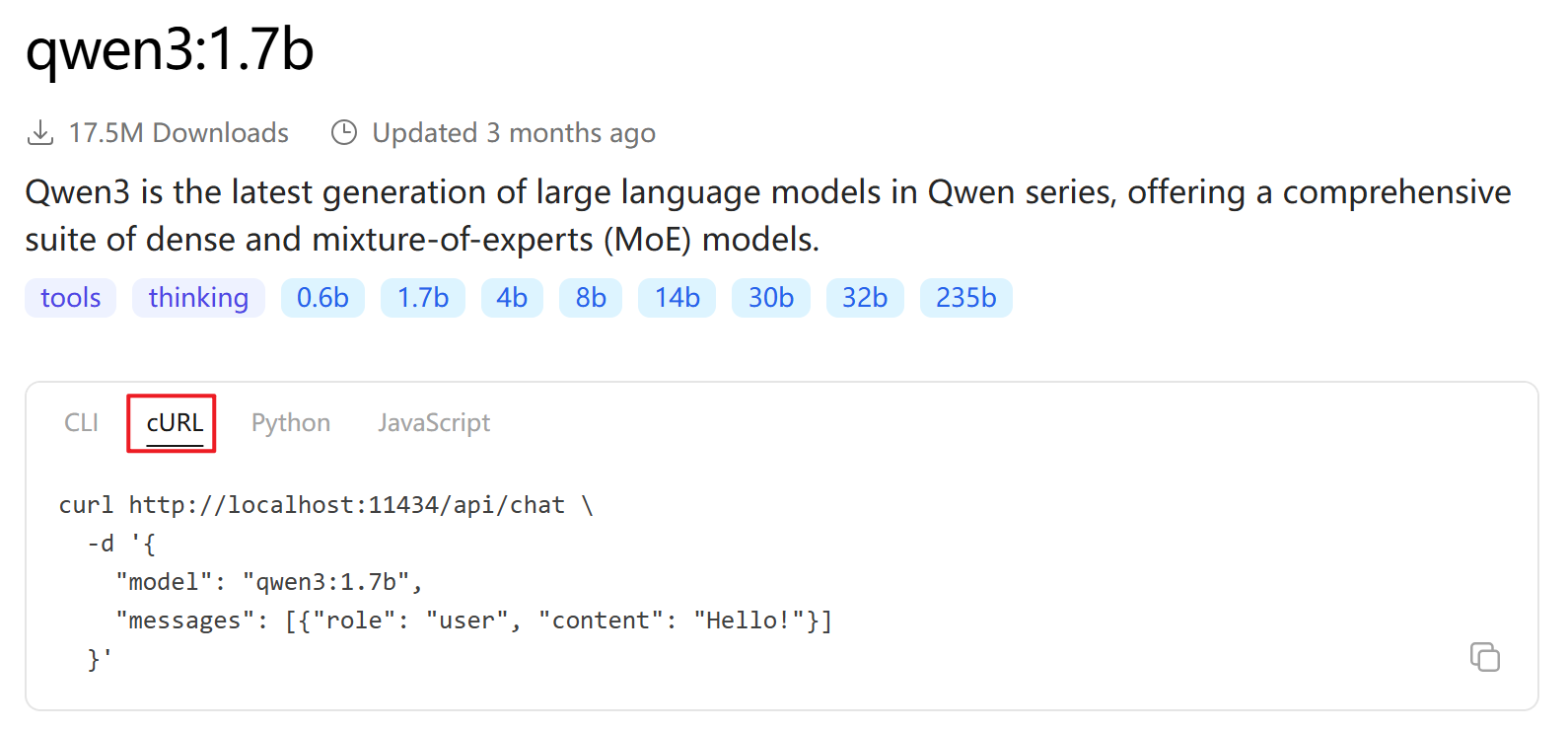

来到Ollama官网,找到qwen3模型,根据自己电脑配置情况,选择下载对应的模型。

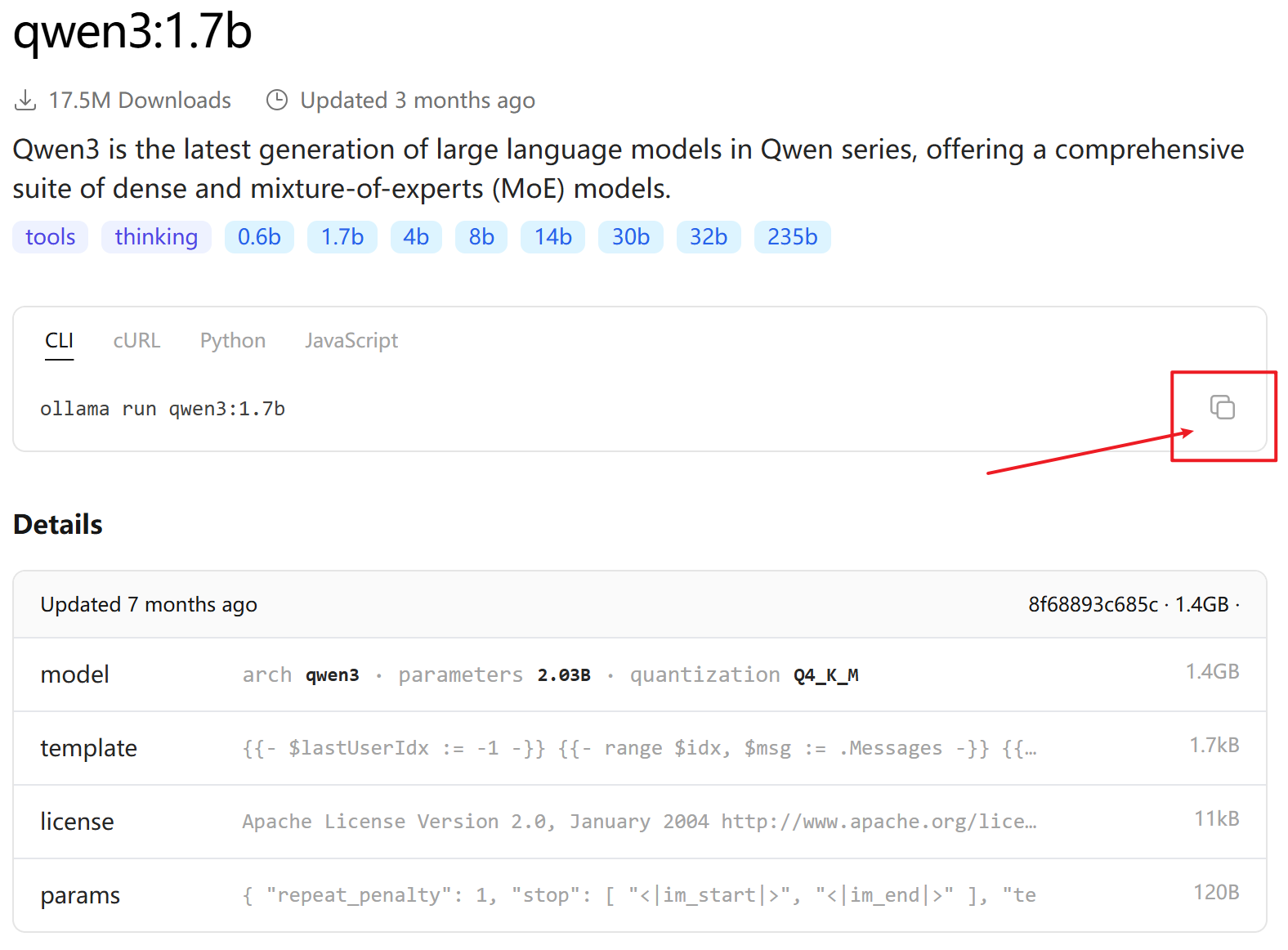

以qwen3:1.7b模型为例,复制CLI命令ollama run qwen3:1.7b,来到命令行窗口,粘贴命令执行。

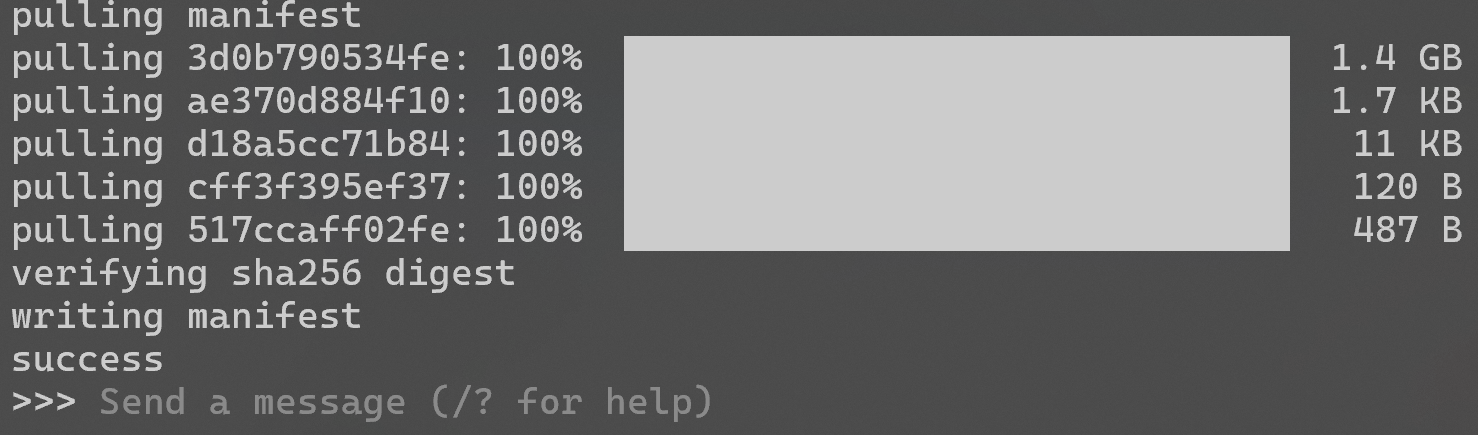

下载完成后直接就进入到了与qwen3:1.7b模型对话的界面。

这时候可以随便输入一些对话,模型就会做出回答,当输入/?可输出命令帮助信息,输入/bye则会退出对话。当第二次再去运行ollama run qwen3:1.7b时就会立即进入对话页面。

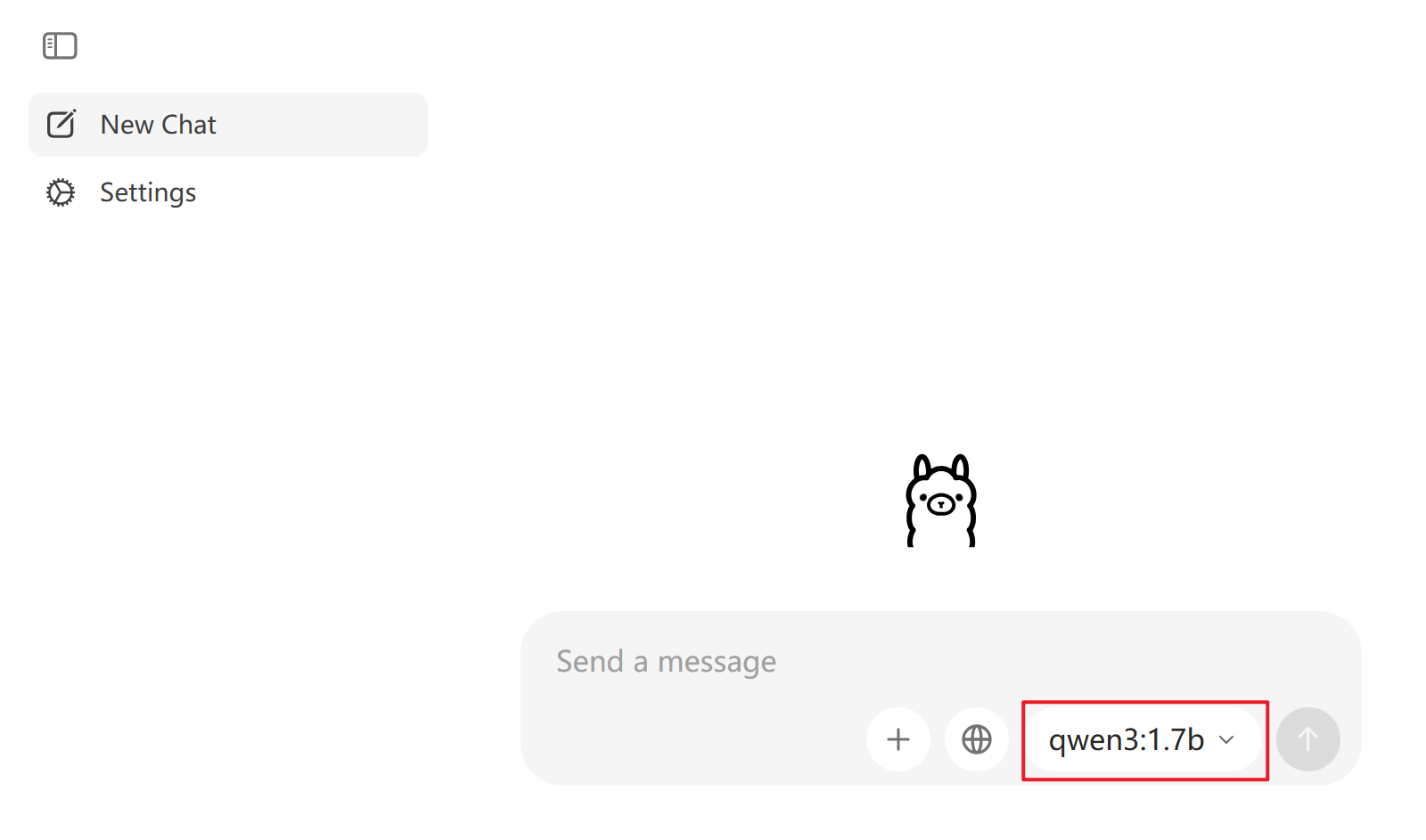

除此之外,打开Ollama客户端,可以看到刚才下载的qwen3:1.7b模型已经可以直接使用了:

在API测试工具中使用

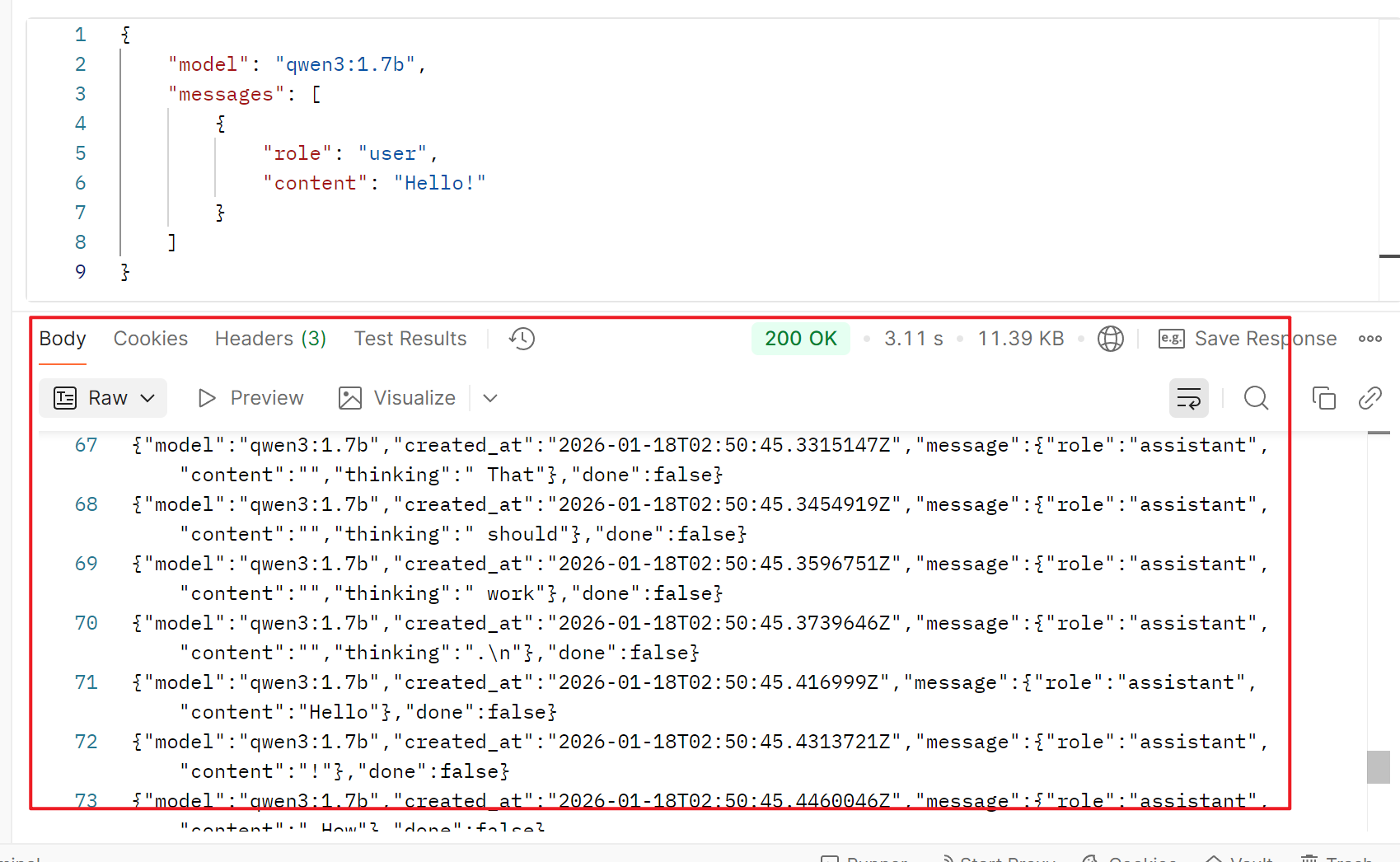

除了使用命令行运行对话外,也可以在API测试工具中测试模型对话。先来到刚才复制下载qwen3:1.7b的那个页面,复制cURL命令:

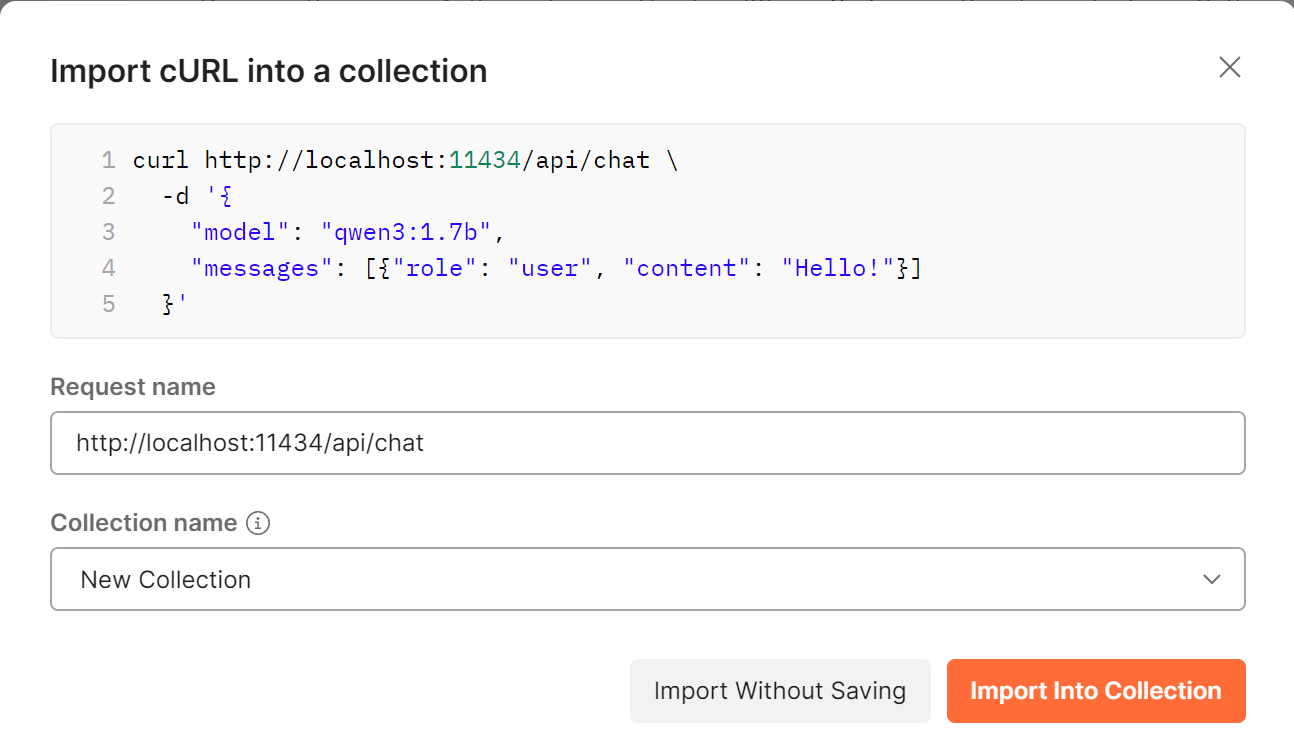

打开postman,通过import粘贴复制的cURL命令,然后点击Import Into Collection:

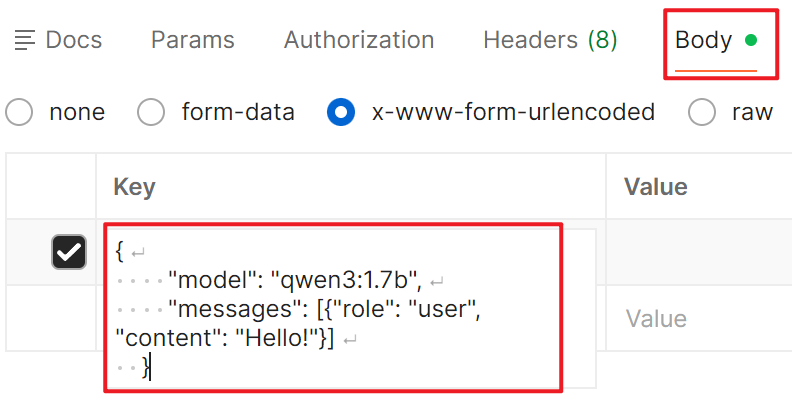

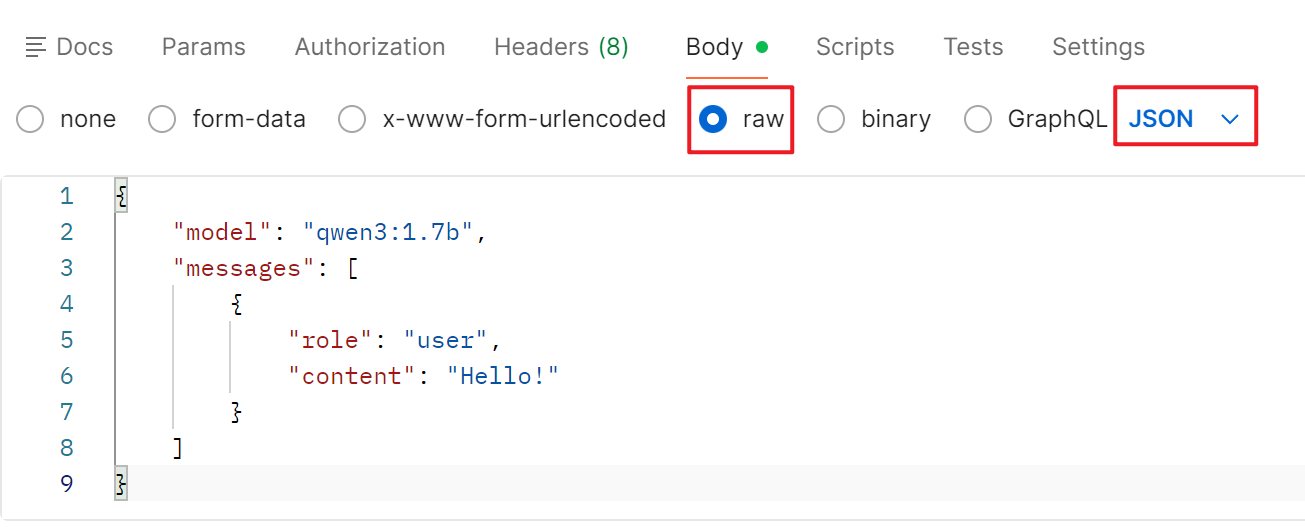

postman就会解析参数,需要注意的是,因postman默认以x-www-form-urlencoded格式解析,需要把body下面的参数复制下来,粘贴到raw中的JSON格式里。

然后点击Send,即可看到下面的输出:

也可以使用下面的命令直接粘贴,这样就不用重新更改传参格式了:

curl http://localhost:11434/api/chat \

-H "Content-Type: application/json" \

-d '{

"model": "qwen3:1.7b",

"messages": [{"role": "user", "content": "Hello!"}]

}'

-d 传参里的

messages中的content就是你向大模型发起的对话内容。可以更改成别的内容看大模型会返回哪些回复。

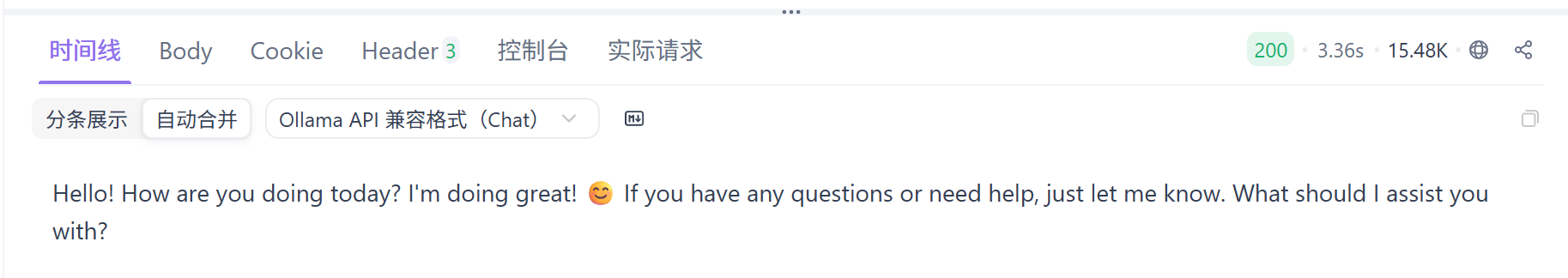

除此之外,国内的apifox也是一个不错的API测试功能,这里就不再赘述了,用法与postman基本相似。

apifox好的一点是可以查看数据合并后的内容(自动合并):

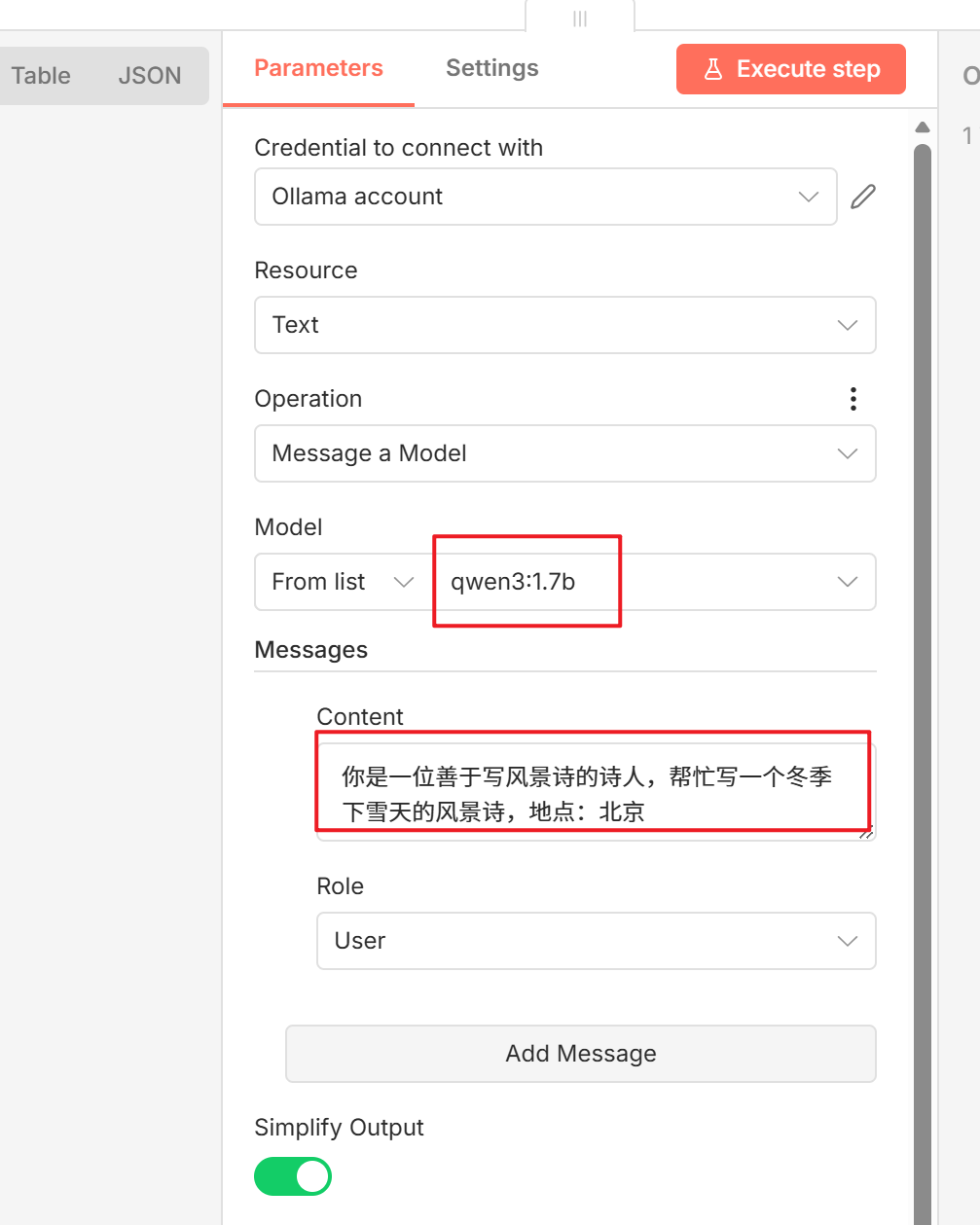

添加Ollama节点

回到n8n中,我们可以删掉AI Agent那个节点,添加Ollama节点(Message a model),配置如下:

Model中可以选择你下载的本地模型,下方的Messages是与AI交互时填写的Prompt。

n8n 作为轻量且灵活的工作流自动化工具,它不仅能轻松实现数组的逐行 / 定时分批处理,更能无缝衔接本地服务(如 Ollama、数据库)与云端应用(如微信、钉钉、各类 API),把数据流转、定时执行、AI 调用、文件操作等重复工作全部串联成自动化流程。无论是个人轻量的日常效率提升,还是小团队的业务流程简化,本地部署的 n8n 都能以低代码的方式,让你摆脱机械操作,把精力聚焦在更有价值的工作上。不妨继续探索各类节点的组合与配置,让 n8n 成为你的「自动化生产力助手」,解锁更多高效的工作流玩法。